Overvej hvad PCA gør. Simpelthen opretter PCA (som oftest kørt) et nyt koordinatsystem ved at:

- flytte oprindelsen til centret af dine data,

- klemmer og / eller strækker akser for at gøre dem ens i længden, og

- roterer dine akser til en ny retning.

(Se denne fremragende CV-tråd for flere detaljer: Fornuftig analyse af hovedkomponentanalyse, egenvektorer & egenværdier.) Det roterer dog ikke bare din akser på en gammel måde. Din nye $ X_1 $ (den første hovedkomponent) er orienteret i dine datas retning for maksimal variation. Den anden hovedkomponent er orienteret i retning af den næststørste mængde variation der er vinkelret på den første hovedkomponent . De resterende hovedkomponenter dannes ligeledes.

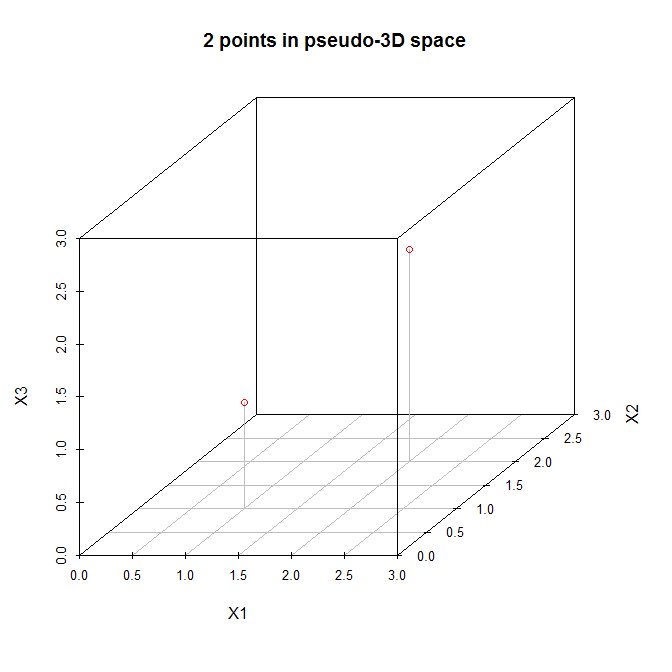

Med dette i tankerne, lad os undersøge @ amoebas eksempel. Her er en datamatrix med to punkter i et tredimensionelt rum:

$$ X = \ bigg [\ begin {array} {ccc} 1 &1 &1 \\ 2 &2 &2 \ end {array} \ bigg] $$ Lad os se disse punkter i et (pseudo) tredimensionelt spredningsdiagram:

Så lad os følge de trin, der er anført ovenfor. (1) Oprindelsen af det nye koordinatsystem ligger på $ (1,5, 1,5, 1,5) $. (2) Akserne er allerede lige. (3) Den første hovedkomponent vil gå diagonalt fra $ (0,0,0) $ til $ (3,3,3) $, hvilket er retningen for den største variation for disse data. Nu skal den anden hovedkomponent være vinkelret på den første og skulle gå i retning af den største tilbageværende variation. Men hvilken retning er det? Er det fra $ (0,0,3) $ til $ (3,3,0) $ eller fra $ (0,3,0) $ til $ (3,0,3) $ eller noget andet? Der er ingen resterende variation, så der kan ikke være flere hovedkomponenter .

Med $ N = 2 $ data kan vi (højst) passe $ N-1 = 1 $ hovedkomponenter.